Wie lernen „intelligente“ Systeme? Warum sollten wir das verstehen?

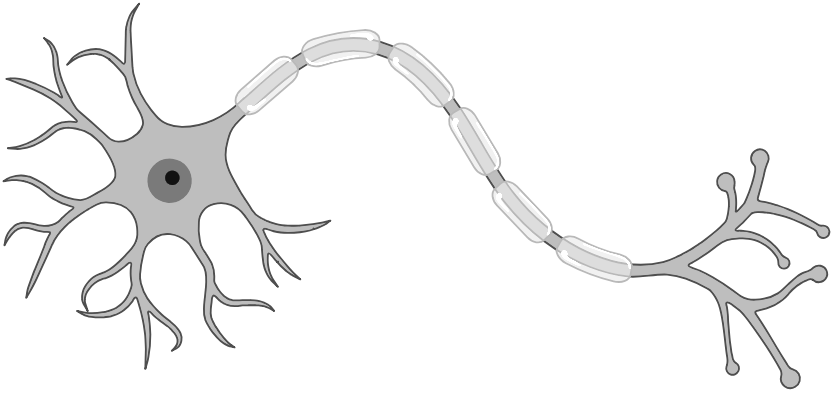

Hier können Sie mithilfe von interessanten Kurzfilmen erfahren, wie künstliche neuronale Netze mithilfe von großen Datenmengen lernen, komplexe Probleme zu lösen. Diese Technologie kommt in den modernen KI-Systemen zum Einsatz und nimmt bereits spürbaren Einfluss auf unsere Gesellschaft.

Wir wollen deshalb ein fundamentales und bisher weitestgehend ungelöstes Problem dieser Systeme ansprechen: Ihre mangelnde Erklärbarkeit. Neuronale Netze rechtfertigen ihre Entscheidungen nicht. Damit können wir als Gesellschaft und Nutzer Entscheidungen der KI nicht verstehen und bewerten.

Eine sich erklärenden KI (‚explainable AI‘) kann sich dagegen erklären, und uns Menschen oder der Gesellschaft damit erlauben diskutieren zu können ob wir mit den Werten und Regeln der KI einverstanden sind oder Veränderungen vornehmen möchten.

Damit ist erklärbare KI eine notwendige Voraussetzung für eine selbstbestimmte menschliche Gesellschaft die das Nutzen und die Gefahren von KI versteht und gegeneinander abwägt.

Gerade in den Bereichen bei denen KI heute bereits wichtige Entscheidungen Trifft, z.B. in der Medizin, oder der Bewertung von Verhaltensmustern von Menschen, aber auch in dem Bereich der Autonomen Fahrzeuge ist es deshalb notwendig sich erklärende KI zu nutzen.

Schließen

Schließen